参考:

说明:没有明确说明是只在某一个节点上做的,就是两个节点都做

mysql软件我们之前已完成二进制安装,直接初始化即可

"箭头指向谁是主库"

两个分片,每个分片四个mysql节点

shard1:

shard1

db01

这个复制用户在谁上建都行

注:如果中间出现错误,在每个节点进行执行以下命令

常见方案:

Alibaba cobar 阿里

Mycat 开源

TDDL 淘宝

Heisenberg 百度

Vitess 谷歌

OneProxy

DRDS 阿里云

我们装的是openjdk,不是官方的那个

Mycat-server-xxxxx.linux.tar.gz

配置环境变量

我们mycat的命令也是在bin目录下

启动

连接mycat:

db01:

我们一般先把原schema.xml备份,然后自己新写一个:

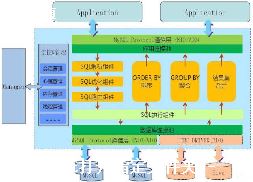

xml和html看起来差不多,xml是从下往上调用的

前三行我们不用看,直接从第四行schema开始看起:

定义了schema,然后以/schema结尾

为什么要用逻辑库?

业务透明化

此配置文件就是实现读写分离的配置

重启mycat

读写分离测试

总结:

以上案例实现了1主1从的读写分离功能,写操作落到主库,读操作落到从库.如果主库宕机,从库不能在继续提供服务了.

我们推荐这种架构

一写三读,

不设置双写的原因是:性能没提升多少,反而引起主键冲突的情况

配置文件:

之后重启:mycat restart

真正的 writehost:负责写操作的writehost

standby writeHost :和readhost一样,只提供读服务

我们此处写了两个writehost,默认使用第一个

当写节点宕机后,后面跟的readhost也不提供服务,这时候standby的writehost就提供写服务,

后面跟的readhost提供读服务

测试:

balance属性

writeType属性

switchType属性

-1 表示不自动切换

①. 默认值,自动切换

datahost其他配置

dataHost name="localhost1" maxCon="1000" minCon="10" balance="1" writeType="0" dbType="mysql" dbDriver="native" switchType="1"

maxCon="1000":最大的并发连接数

minCon="10" :mycat在启动之后,会在后端节点上自动开启的连接线程,长连接,好处是连接速度快,弊端是占内存

tempReadHostAvailable="1"

heartbeatselect user()/heartbeat 监测心跳

其他参数sqlMaxLimit自动分页,必须在启用分表的情况下才生效

创建测试库和表:

发现跟一个库一样,实际上已经分到不同的物理硬件上了

热点数据表 核心表

分片的目的:

(1)将大数据量进行分布存储

分片策略:

取模 mod (取余数) 和节点的数量进行取模

枚举 按枚举的种类分,如移动项目按省份分

哈希 hash

时间 流水

优化关联查询(否则join的表在不同分片上,效率会比单库还要低)

全局表

ER分片

案例:移动统一:先拆出边缘业务,再按地域分片,但对应用来说是统一的

vim rule.xml

tableRule name="auto-sharding-long"

rule

columnsid/columns

algorithmrang-long/algorithm

/rule

function name="rang-long"

class="io.mycat.route.function.AutoPartitionByLong"

property name="mapFile"autopartition-long.txt/property

/function

===================================

vim autopartition-long.txt

0-10=0

创建测试表:

mycat restart

取余分片方式:分片键(一个列)与节点数量进行取余,得到余数,将数据写入对应节点

vim schema.xml

准备测试环境

use TESTDB

分别登录后端节点查询数据

use taobao

id name telnum

sharding-by-intfile

tableRule name="sharding-by-intfile"

rule columnsname/columns

algorithmhash-int/algorithm

/tableRule

function name="hash-int" class="org.opencloudb.route.function.PartitionByFileMap"

property name="mapFile"partition-hash-int.txt/property

property name="type"1/property

property name="defaultNode"0/property

partition-hash-int.txt 配置:

bj=0

sh=1

DEFAULT_NODE=1

columns 标识将要分片的表字段,algorithm 分片函数, 其中分片函数配置中,mapFile标识配置文件名称

a b c d

join

t

select t1.name ,t.x from t1

join t

使用场景:

如果你的业务中有些数据类似于数据字典,比如配置文件的配置,

常用业务的配置或者数据量不大很少变动的表,这些表往往不是特别大,

而且大部分的业务场景都会用到,那么这种表适合于Mycat全局表,无须对数据进行切分,

要在所有的分片上保存一份数据即可,Mycat 在Join操作中,业务表与全局表进行Join聚合会优先选择相同分片内的全局表join,

避免跨库Join,在进行数据插入操作时,mycat将把数据分发到全局表对应的所有分片执行,在进行数据读取时候将会随机获取一个节点读取数据.

后端数据准备

insert into t_area(id,name) values(1,'a');

A

B

为了防止跨分片join,可以使用E-R模式

A join B

on a.xx=b.yy

join C

on A.id=C.id

childTable name="B" joinKey="yy" parentKey="xx" /

/table

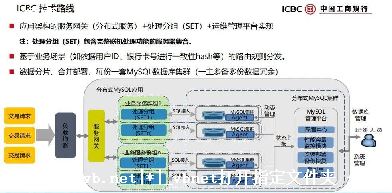

当前做分布式的厂商有几家,我知道比较出名的有"华为云分布式数据库DDM"和"阿里云分布式数据库",感兴趣可以自行搜素了解下.

分布式数据库的几点概念可以了解一下.

数据分库:

以表为单位,把原有数据库切分成多个数据库.切分后不同的表存储在不同的数据库上.

以表中的数据行记录为单位,把原有逻辑数据库切分成多个物理数据库分片,表数据记录分布存储在各个分片上.

路由分发:

在分布式数据库中,路由的作用即将SQL语句进行解析,并转发到正确的分片上,保证SQL执行后得到正确的结果,并且节约QPS资源.

读写分离:

数据库中对计算和缓存资源消耗较多的往往是密集或复杂的SQL查询.当系统资源被查询语句消耗,反过来会影响数据写入操作,进而导致数据库整体性能下降,响应缓慢.所以呢,当数据库CPU和内存资源占用居高不下,且读写比例较高时,可以为数据库添加只读数据库.

mysql没有分布式功能

如果你要实现类似分布式mysql的功能,一般都是需要中间件的,你可以看下mycat相关资料

①.、主要解决针对大型网站架构中持久化部分中,大量数据存储以及高并发访问所带来是数据读写问题.分布式是将一个业务拆分为多个子业务,部署在不同的服务器上.集群是同一个业务,部署在多个服务器上.

通过分布式+集群的方式来提高io的吞吐量,以及数据库的主从复制,主主复制,负载均衡,高可用,分库分表以及数据库中间件的使用.

以前参加过一个库存系统,由于其业务复杂性,搞了很多个应用来支撑.这样的话一份库存数据就有可能同时有多个应用来修改库存数据.

比如说,有定时任务域xx.cron,和SystemA域和SystemB域这几个JAVA应用,可能同时修改同一份库存数据.如果不做协调的话,就会有脏数据出现.

对于跨JAVA进程的线程协调,可以借助外部环境,例如DB或者Redis.下文介绍一下如何使用DB来实现分布式锁.

本文设计的分布式锁的交互方式如下:

在使用synchronized关键字的时候,必须指定一个锁对象.

进程内的线程可以基于obj来实现同步.obj今天这一节可以理解为一个锁对象.如果线程要进入synchronized代码块里,必须先持有obj对象上的锁.这种锁是JAVA里面的内置锁,创建的过程是线程安全的.那么借助DB,如何保证创建锁的过程是线程安全的呢?

可以利用DB中的UNIQUE KEY特性,一旦出现了重复的key,由于UNIQUE KEY的唯一性,会抛出异常的.在JAVA里面,是 SQLIntegrityConstraintViolationException 异常.

transaction_id是事务Id,比如说,可以用

来组装一个transaction_id,表示某仓库某销售模式下的某个条码资源.不同条码,当然就有不同的transaction_id.如果有两个应用,拿着相同的transaction_id来创建锁资源的时候,只能有一个应用创建成功.

在写操作频繁的业务系统中,通常会进行分库,以降低单数据库写入的压力,并提高写操作的吞吐量.如果使用了分库,那么业务数据自然也都分配到各个数据库上了.

在这种水平切分的多数据库上使用DB分布式锁,可以自定义一个DataSouce列表.并暴露一个 getConnection(String transactionId) 方法,按照transactionId找到对应的Connection.

实现代码如下:

首先编写一个initDataSourceList方法,并利用Spring的PostConstruct注解初始化一个DataSource 列表.相关的DB配置从db.properties读取.

DataSource使用阿里的DruidDataSource.

接着最重要的一个实现getConnection(String transactionId)方法.实现原理很简单,获取transactionId的hashcode,并对DataSource的长度取模即可.

连接池列表设计好后,就可以实现往distributed_lock表插入数据了.

此时此刻呢利用DB的 select for update 特性来锁住线程.当多个线程根据相同的transactionId并发同时操作 select for update 的时候,只有一个线程能成功,其他线程都block住,直到 select for update 成功的线程使用commit操作后,block住的所有线程的其中一个线程才能开始干活.

我们在上面的DistributedLock类中创建一个lock方法.

当线程执行完任务后,必须手动的执行解锁操作,之前被锁住的线程才能继续干活.在我们上面的实现中,其实就是获取到当时 select for update 成功的线程对应的Connection,并实行commit操作即可.

那么如何获取到呢?我们可以利用ThreadLocal.首先在DistributedLock类中定义

每次调用lock方法的时候,把Connection放置到ThreadLocal里面.我们修改lock方法.

这样子,当获取到Connection后,将其设置到ThreadLocal中,如果lock方法出现异常,则将其从ThreadLocal中移除掉.

有了这几步后,我们可以来实现解锁操作了.我们在DistributedLock添加一个unlock方法.

毕竟是利用DB来实现分布式锁,对DB还是造成一定的压力.当时考虑使用DB做分布式的一个重要原因是,我们的应用是后端应用,平时流量不大的,反而关键的是要保证库存数据的正确性.对于像前端库存系统,比如添加购物车占用库存等操作,最好别使用DB来实现分布式锁了.

如果想锁住多份数据该怎么实现?比如说,某个库存操作,既要修改物理库存,又要修改虚拟库存,想锁住物理库存的同时,又锁住虚拟库存.其实也不是很难,参考lock方法,写一个multiLock方法,提供多个transactionId的入参,for循环处理就可以了.这个后续有时间再补上.