使用jsoup解析到这个url就行,dom结构如下:

look-inside-cover类只有一个,所以直接找到这个img元素,获取src属性,就可以获取到图片路径.

代码实现如下:

Document?doc?=?Jsoup.connect("").get();

Elements?imgs?=?doc.select(".look-inside-cover");

String?imgUrl?=?imgs.get(0).attr("src");

jsoup的jar包分享给你:

实现思路:一次性读取选中的统一路径下的多张图片,实现整体复制.

//复制文件夹

package com.cdd.util;

import java.io.*;

public class FileUtil {

private static void copy(File[] files, File d) {

if (!d.exists()) //如果指定目录不存在

d.mkdir(); //创建目录

for (int i = 0; i files.length; i++) { //循环遍历要复制的文件夹

if (files[i].isFile()) { //如果文件夹中是文件

try {

FileInputStream fis = new FileInputStream(files[i]); //创建FileInputStream对象

FileOutputStream out = new FileOutputStream(new File(d

.getPath()

+ File.separator + files[i].getName())); //复制后文件的保存路径

int count = fis.available();

byte[] data = new byte[count];

while ((str = bre.readLine())!= null) //读取文件通过readline方法可以有效的避免乱码

out.write(str ); //将读取的信息写入文件中

}

out.close(); //关闭流

fis.close();

} catch (Exception e) {

e.printStackTrace();

if (files[i].isDirectory()) { //如果文件夹中是一个路径

File des = new File(d.getPath() + File.separator

+ files[i].getName()); //在复制后路径中创建子文件夹

des.mkdir();

copy(files[i].listFiles(), des); //再次调用本方法

System.out.println("文件夹复制成功");

import java.awt.*;

import java.awt.event.*;

import java.net.*;

import java.util.*;

import java.util.regex.*;

import javax.swing.*;

import javax.swing.table.*;//一个Web的爬行者(注:爬行今天这一节的意思与抓取,捕获相同)

public class SearchCrawler extends JFrame{

//最大URL保存值

//缓存robot禁止爬行列表

private HashMap disallowListCache=new HashMap();

//搜索GUI控件

private JTextField startTextField;

private JComboBox maxComboBox;

private JCheckBox limitCheckBox;

private JTextField logTextField;

private JTextField searchTextField;

private JCheckBox caseCheckBox;

private JButton searchButton;

//搜索状态GUI控件

private JProgressBar progressBar;

//搜索匹配项表格列表

private JTable table;

//标记爬行机器是否正在爬行

private boolean crawling;

//写日志匹配文件的引用

private PrintWriter logFileWriter;

//网络爬行者的构造函数

public SearchCrawler(){

//设置应用程序标题栏

setTitle("搜索爬行者");

//设置窗体大小

//处理窗体关闭事件

addWindowListener(new WindowAdapter(){

public void windowClosing(WindowEvent e){

actionExit();

});

//设置文件菜单

JMenuBar menuBar=new JMenuBar();

JMenu fileMenu=new JMenu("文件");

fileMenu.setMnemonic(KeyEvent.VK_F);

JMenuItem fileExitMenuItem=new JMenuItem("退出",KeyEvent.VK_X);

fileExitMenuItem.addActionListener(new ActionListener(){

public void actionPerformed(ActionEvent e){

fileMenu.add(fileExitMenuItem);

menuBar.add(fileMenu);

setJMenuBar(menuBar);

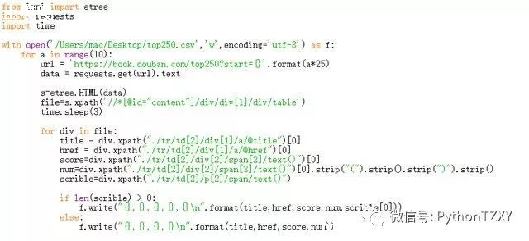

通过httpclient来爬取网站内容,分析当前内容页中的图片'规则'

抓取一般都是模拟浏览器访问目标网页,通过返回的页面html代码进行分析自己需要的数据

查找规则,例如你爬取的网页 ,看到当前页面显示的图片格式如下img src=""

你可以搜索,java爬虫(httpclient)和htmlpaser做更多的了解.

以上就是土嘎嘎小编为大家整理的java爬虫多张图片代码相关主题介绍,如果您觉得小编更新的文章只要能对粉丝们有用,就是我们最大的鼓励和动力,不要忘记讲本站分享给您身边的朋友哦!!